mirror of

https://github.com/Ladebeze66/llm_ticket3.git

synced 2026-02-04 05:50:23 +01:00

2104-16:56

This commit is contained in:

parent

826f2cde93

commit

797607f566

@ -1,4 +1,4 @@

|

||||

ÉMETTEUR,TYPE,DATE,CONTENU,ÉLÉMENTS VISUELS

|

||||

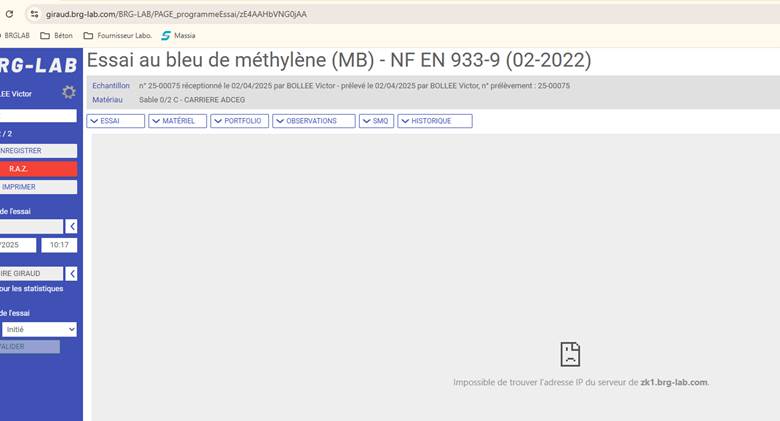

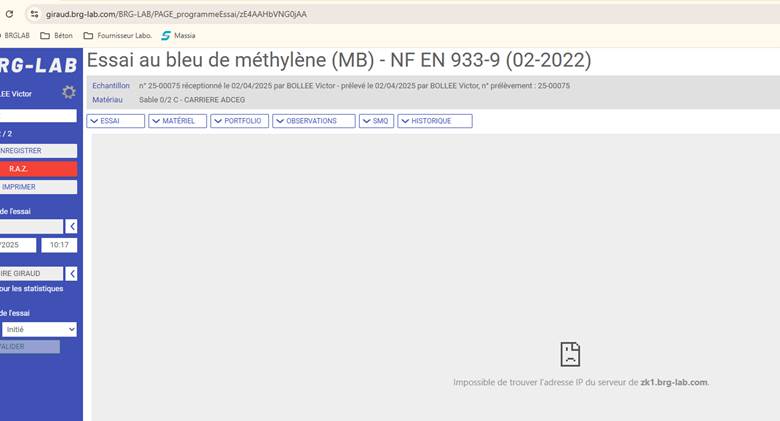

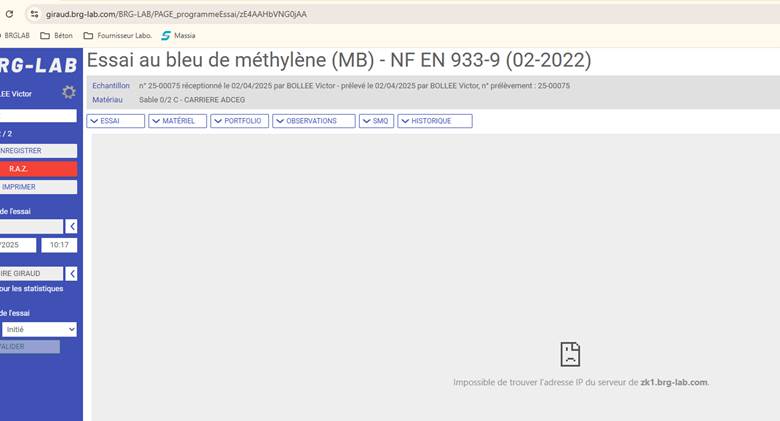

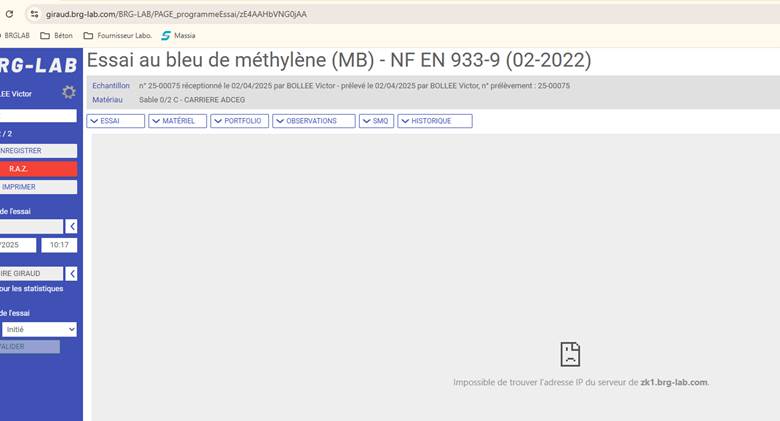

CLIENT,question,03/04/2025 08:34,"Bonjour, Je ne parviens pas à accéder au l’essai au bleu : Merci par avance pour votre. Cordialement","Message d'erreur : ""Impossible de trouver l'adresse IP du serveur de zk1.brg-lab.com"" (image_145435.png)"

|

||||

SUPPORT,réponse,03/04/2025 12:17,"Bonjour, Pouvez-vous vérifier si vous avez bien accès à la page suivante en l'ouvrant dans votre navigateur : https://zk1.brg-lab.com/ Voici ce que vous devriez voir affiché : Si ce n'est pas le cas, pouvez-vous me faire une capture d'écran de ce qui est affiché? Je reste à votre entière disposition pour toute information complémentaire. Cordialement,","Page de succès de Tomcat : ""If you're seeing this page via a web browser, it means you've setup Tomcat successfully! Congratulations!"" (image.png)"

|

||||

CLIENT,information,03/04/2025 12:21,"Bonjour, Le problème s’est résolu seul par la suite. Je vous remercie pour votre retour. Bonne journée PS : l’adresse fonctionne","Page de succès de Tomcat : ""If you're seeing this page via a web browser, it means you've setup Tomcat successfully! Congratulations!"" (image.png)"

|

||||

CLIENT,question,03/04/2025 08:34,Je ne parviens pas à accéder à l’essai au bleu.,L'image (image_145435.png) montre que l'essai au bleu de méthylène (MB) est accessible.

|

||||

SUPPORT,réponse,03/04/2025 12:17,Pouvez-vous vérifier si vous avez bien accès à la page suivante en l'ouvrant dans votre navigateur : https://zk1.brg-lab.com/,L'image (image.png) confirme que la page https://zk1.brg-lab.com/ est accessible et que Tomcat est correctement installé.

|

||||

CLIENT,information,03/04/2025 12:21,Le problème s’est résolu seul par la suite. Je vous remercie pour votre retour. Bonne journée PS : l’adresse fonctionne,L'image (image_145435.png) indique un problème de connexion ou de configuration réseau avec l'adresse IP du serveur de zk1.brg-lab.com.

|

||||

|

||||

|

@ -1,2 +1,2 @@

|

||||

Question,Réponse,Contexte Question,Contexte Réponse

|

||||

"Bonjour, Je ne parviens pas à accéder au l’essai au bleu : Merci par avance pour votre. Cordialement","Bonjour, Pouvez-vous vérifier si vous avez bien accès à la page suivante en l'ouvrant dans votre navigateur : https://zk1.brg-lab.com/ Voici ce que vous devriez voir affiché : Si ce n'est pas le cas, pouvez-vous me faire une capture d'écran de ce qui est affiché? Je reste à votre entière disposition pour toute information complémentaire. Cordialement,","Message d'erreur : ""Impossible de trouver l'adresse IP du serveur de zk1.brg-lab.com"" (image_145435.png)","Page de succès de Tomcat : ""If you're seeing this page via a web browser, it means you've setup Tomcat successfully! Congratulations!"" (image.png)"

|

||||

Je ne parviens pas à accéder à l’essai au bleu.,Pouvez-vous vérifier si vous avez bien accès à la page suivante en l'ouvrant dans votre navigateur : https://zk1.brg-lab.com/,L'image (image_145435.png) montre que l'essai au bleu de méthylène (MB) est accessible.,L'image (image.png) confirme que la page https://zk1.brg-lab.com/ est accessible et que Tomcat est correctement installé.

|

||||

|

||||

|

@ -1,10 +1,9 @@

|

||||

from ..base_agent import BaseAgent

|

||||

from typing import Any, Dict

|

||||

import logging

|

||||

import os

|

||||

from typing import Dict, Any

|

||||

from PIL import Image

|

||||

import base64

|

||||

import io

|

||||

from ..utils.pipeline_logger import sauvegarder_donnees

|

||||

|

||||

logger = logging.getLogger("AgentImageAnalyser")

|

||||

|

||||

@ -15,247 +14,166 @@ class AgentImageAnalyser(BaseAgent):

|

||||

def __init__(self, llm):

|

||||

super().__init__("AgentImageAnalyser", llm)

|

||||

|

||||

# Configuration locale de l'agent

|

||||

self.temperature = 0.2

|

||||

self.top_p = 0.9

|

||||

self.max_tokens = 3000

|

||||

# Configuration personnalisable

|

||||

self.params = {

|

||||

"temperature": 0.2,

|

||||

"top_p": 0.8,

|

||||

"max_tokens": 3000

|

||||

}

|

||||

|

||||

# Centralisation des instructions d'analyse pour éviter la duplication

|

||||

self.instructions_analyse = """

|

||||

1. Description objective

|

||||

Décris précisément ce que montre l'image :

|

||||

- Interface logicielle, menus, fenêtres, onglets

|

||||

- Messages d'erreur, messages système, code ou script

|

||||

- Nom ou titre du logiciel ou du module si visible

|

||||

self.instructions_analyse = (

|

||||

"""

|

||||

1. Description objective

|

||||

Décris précisément ce que montre l'image :

|

||||

- Interface logicielle, menus, fenêtres, onglets

|

||||

- Messages d'erreur, messages système, code ou script

|

||||

- Nom ou titre du logiciel ou du module si visible

|

||||

- Distingue clairement le nom complet des essais/tests/modules (par exemple, "Essai au bleu de méthylène" au lieu de simplement "essai bleu")

|

||||

|

||||

2. Éléments techniques clés

|

||||

Identifie :

|

||||

- Versions logicielles ou modules affichés

|

||||

- Codes d'erreur visibles

|

||||

- Paramètres configurables (champs de texte, sliders, dropdowns, cases à cocher)

|

||||

- Valeurs affichées ou préremplies dans les champs

|

||||

- Éléments désactivés, grisés ou masqués (souvent non modifiables)

|

||||

- Boutons actifs/inactifs

|

||||

2. Éléments techniques clés

|

||||

Identifie :

|

||||

- Versions logicielles ou modules affichés

|

||||

- Codes d'erreur visibles

|

||||

- Paramètres configurables (champs de texte, sliders, dropdowns, cases à cocher)

|

||||

- Valeurs affichées ou préremplies dans les champs

|

||||

- Éléments désactivés, grisés ou masqués (souvent non modifiables)

|

||||

- Boutons actifs/inactifs

|

||||

- Boutons RAZ ou réinitialisation (souvent marqués "RAZ" et non "PAZ")

|

||||

- Précise si des éléments colorés font partie de l'interface standard (ex: bouton toujours rouge) ou s'ils semblent être liés au problème

|

||||

|

||||

3. Éléments mis en évidence

|

||||

- Recherche les zones entourées, encadrées, surlignées ou fléchées

|

||||

- Ces éléments sont souvent importants pour le client ou le support

|

||||

- Mentionne explicitement leur contenu et leur style de mise en valeur

|

||||

3. Éléments mis en évidence

|

||||

- Recherche les zones entourées, encadrées, surlignées ou fléchées

|

||||

- Ces éléments sont souvent importants pour le client ou le support

|

||||

- Mentionne explicitement leur contenu et leur style de mise en valeur

|

||||

- Vérifie spécifiquement si des messages d'erreur sont visibles en bas ou en haut de l'écran

|

||||

|

||||

4. Relation avec le problème

|

||||

- Établis le lien entre les éléments visibles et le problème décrit dans le ticket

|

||||

- Indique si des composants semblent liés à une mauvaise configuration ou une erreur

|

||||

4. Relation avec le problème

|

||||

- Établis le lien entre les éléments visibles et le problème décrit dans le ticket

|

||||

- Indique si des composants semblent liés à une mauvaise configuration ou une erreur

|

||||

- Précise le nom complet du module/essai concerné par le problème (par exemple "Essai au bleu de méthylène (MB)" et pas seulement "essai bleu")

|

||||

- Identifie si l'utilisateur a accès à l'écran d'essai mais avec des erreurs, ou s'il n'y a pas d'accès du tout

|

||||

|

||||

5. Réponses potentielles

|

||||

- Détermine si l'image apporte des éléments de réponse à une question posée dans :

|

||||

- Le titre du ticket

|

||||

- La description du problème

|

||||

5. Réponses potentielles

|

||||

- Détermine si l'image apporte des éléments de réponse à une question posée dans :

|

||||

- Le titre du ticket

|

||||

- La description du problème

|

||||

- Tente d'extrapoler le contexte technique précis en observant l'interface (ex: "l'essai au bleu" mentionné par le client correspond clairement à "l'essai au bleu de méthylène (MB) - NF EN 933-9")

|

||||

|

||||

6. Lien avec la discussion

|

||||

- Vérifie si l'image fait écho à une étape décrite dans le fil de discussion

|

||||

- Note les correspondances (ex: même module, même message d'erreur que précédemment mentionné)

|

||||

6. Lien avec la discussion

|

||||

- Vérifie si l'image fait écho à une étape décrite dans le fil de discussion

|

||||

- Note les correspondances (ex: même module, même message d'erreur que précédemment mentionné)

|

||||

- Établis des connections explicites entre le vocabulaire utilisé par le client et ce qui est visible dans l'interface

|

||||

|

||||

Règles importantes :

|

||||

- Ne fais AUCUNE interprétation ni diagnostic

|

||||

- Ne propose PAS de solution ou recommandation

|

||||

- Reste strictement factuel et objectif

|

||||

- Concentre-toi uniquement sur ce qui est visible dans l'image

|

||||

- Reproduis les textes exacts(ex : messages d'erreur, libellés de paramètres)

|

||||

- Prête une attention particulière aux éléments modifiables (interactifs) et non modifiables (grisés)

|

||||

"""

|

||||

7. Contexte technique élargi

|

||||

- Identifie le contexte plus large de l'application (laboratoire, tests techniques, essais normalisés)

|

||||

- Relève toutes les références à des normes ou standards (ex: NF EN 933-9)

|

||||

- Mentionne tous les codes ou identifiants visibles qui pourraient être utiles (ex: numéros d'échantillons)

|

||||

|

||||

# Prompt système construit à partir des instructions centralisées

|

||||

self.system_prompt = f"""Tu es un expert en analyse d'images pour le support technique de BRG-Lab pour la société CBAO.

|

||||

Ta mission est d'analyser des captures d'écran en lien avec le contexte du ticket de support.

|

||||

Règles importantes :

|

||||

- Ne fais AUCUNE interprétation ni diagnostic sur les causes possibles

|

||||

- Ne propose PAS de solution ou recommandation

|

||||

- Reste strictement factuel et objectif, mais fais des liens explicites avec les termes utilisés par le client

|

||||

- Concentre-toi uniquement sur ce qui est visible dans l'image

|

||||

- Reproduis les textes exacts (ex : messages d'erreur, libellés de paramètres)

|

||||

- Prête une attention particulière aux éléments modifiables (interactifs) et non modifiables (grisés)

|

||||

- Utilise systématiquement le nom complet et précis des modules et essais

|

||||

- Vérifie la lecture correcte des boutons et menus (attention aux confusions comme PAZ/RAZ)

|

||||

"""

|

||||

)

|

||||

|

||||

Structure ton analyse d'image de façon factuelle:

|

||||

{self.instructions_analyse}

|

||||

self.system_prompt = (

|

||||

"""

|

||||

Tu es un expert en analyse d'images pour le support technique de BRG-Lab pour la société CBAO.

|

||||

Ta mission est d'analyser des captures d'écran en lien avec le contexte du ticket de support.

|

||||

|

||||

Tu dois être extrêmement précis dans ta lecture des interfaces et des éléments techniques.

|

||||

Les clients utilisent souvent des termes abrégés (comme "essai bleu") alors que l'interface montre le terme complet ("Essai au bleu de méthylène"). Tu dois faire le lien entre ces termes.

|

||||

|

||||

Certains éléments dans l'interface peuvent prêter à confusion :

|

||||

- Les boutons "RAZ" (réinitialisation) sont parfois difficiles à lire

|

||||

- Des éléments en couleur peuvent faire partie de l'interface standard (et non du problème)

|

||||

- Les messages d'erreur sont souvent en bas de l'écran et contiennent des informations cruciales

|

||||

|

||||

Structure ton analyse d'image de façon factuelle:

|

||||

{instructions}

|

||||

|

||||

Ton analyse sera utilisée comme élément factuel pour un rapport technique plus complet et pour faire le lien entre le vocabulaire du client et les éléments techniques réels.

|

||||

"""

|

||||

).format(

|

||||

instructions=self.instructions_analyse

|

||||

)

|

||||

|

||||

Ton analyse sera utilisée comme élément factuel pour un rapport technique plus complet."""

|

||||

|

||||

# Appliquer la configuration au LLM

|

||||

self._appliquer_config_locale()

|

||||

|

||||

logger.info("AgentImageAnalyser initialisé")

|

||||

|

||||

def _appliquer_config_locale(self) -> None:

|

||||

"""

|

||||

Applique la configuration locale au modèle LLM.

|

||||

"""

|

||||

# Appliquer le prompt système

|

||||

if hasattr(self.llm, "prompt_system"):

|

||||

self.llm.prompt_system = self.system_prompt

|

||||

|

||||

# Appliquer les paramètres

|

||||

if hasattr(self.llm, "configurer"):

|

||||

params = {

|

||||

"temperature": self.temperature,

|

||||

"top_p": self.top_p,

|

||||

"max_tokens": self.max_tokens

|

||||

}

|

||||

|

||||

self.llm.configurer(**params)

|

||||

self.llm.configurer(**self.params)

|

||||

|

||||

def _verifier_image(self, image_path: str) -> bool:

|

||||

"""

|

||||

Vérifie si l'image existe et est accessible

|

||||

|

||||

Args:

|

||||

image_path: Chemin vers l'image

|

||||

|

||||

Returns:

|

||||

True si l'image existe et est accessible, False sinon

|

||||

"""

|

||||

try:

|

||||

# Vérifier que le fichier existe

|

||||

if not os.path.exists(image_path):

|

||||

logger.error(f"L'image n'existe pas: {image_path}")

|

||||

if not os.path.exists(image_path) or not os.access(image_path, os.R_OK):

|

||||

return False

|

||||

|

||||

# Vérifier que le fichier est accessible en lecture

|

||||

if not os.access(image_path, os.R_OK):

|

||||

logger.error(f"L'image n'est pas accessible en lecture: {image_path}")

|

||||

return False

|

||||

|

||||

# Vérifier que le fichier peut être ouvert comme une image

|

||||

with Image.open(image_path) as img:

|

||||

# Vérifier les dimensions de l'image

|

||||

width, height = img.size

|

||||

if width <= 0 or height <= 0:

|

||||

logger.error(f"Dimensions d'image invalides: {width}x{height}")

|

||||

return False

|

||||

|

||||

logger.info(f"Image vérifiée avec succès: {image_path} ({width}x{height})")

|

||||

return True

|

||||

return width > 0 and height > 0

|

||||

except Exception as e:

|

||||

logger.error(f"Erreur lors de la vérification de l'image {image_path}: {str(e)}")

|

||||

logger.error(f"Vérification impossible pour {image_path}: {e}")

|

||||

return False

|

||||

|

||||

def _encoder_image_base64(self, image_path: str) -> str:

|

||||

"""

|

||||

Encode l'image en base64 pour l'inclure directement dans le prompt

|

||||

|

||||

Args:

|

||||

image_path: Chemin vers l'image

|

||||

|

||||

Returns:

|

||||

Chaîne de caractères au format data URI avec l'image encodée en base64

|

||||

"""

|

||||

try:

|

||||

# Ouvrir l'image et la redimensionner si trop grande

|

||||

with Image.open(image_path) as img:

|

||||

# Redimensionner l'image si elle est trop grande (max 800x800)

|

||||

max_size = 800

|

||||

if img.width > max_size or img.height > max_size:

|

||||

img.thumbnail((max_size, max_size), Image.Resampling.LANCZOS)

|

||||

|

||||

# Convertir en RGB si nécessaire (pour les formats comme PNG)

|

||||

if img.mode != "RGB":

|

||||

img = img.convert("RGB")

|

||||

|

||||

# Sauvegarder l'image en JPEG dans un buffer mémoire

|

||||

buffer = io.BytesIO()

|

||||

img.save(buffer, format="JPEG", quality=85)

|

||||

buffer.seek(0)

|

||||

|

||||

# Encoder en base64

|

||||

img_base64 = base64.b64encode(buffer.read()).decode("utf-8")

|

||||

|

||||

# Construire le data URI

|

||||

data_uri = f"data:image/jpeg;base64,{img_base64}"

|

||||

|

||||

return data_uri

|

||||

except Exception as e:

|

||||

logger.error(f"Erreur lors de l'encodage de l'image {image_path}: {str(e)}")

|

||||

return ""

|

||||

|

||||

def _generer_prompt_analyse(self, contexte: str, prefix: str = "") -> str:

|

||||

"""

|

||||

Génère le prompt d'analyse d'image en utilisant les instructions centralisées

|

||||

|

||||

Args:

|

||||

contexte: Contexte du ticket à inclure dans le prompt

|

||||

prefix: Préfixe optionnel (pour inclure l'image en base64 par exemple)

|

||||

|

||||

Returns:

|

||||

Prompt formaté pour l'analyse d'image

|

||||

Génère le prompt d'analyse d'image

|

||||

"""

|

||||

return f"""{prefix}

|

||||

|

||||

CONTEXTE DU TICKET:

|

||||

{contexte}

|

||||

|

||||

INSTRUCTIONS IMPORTANTES:

|

||||

- Lis attentivement tous les textes visibles dans l'image et reporte-les avec précision.

|

||||

- Veille à bien distinguer les boutons "RAZ" (réinitialisation) s'ils sont présents.

|

||||

- Identifie précisément le nom complet des essais ou tests mentionnés (ex: "Essai au bleu de méthylène" plutôt que juste "essai bleu").

|

||||

- Si l'interface montre un essai ou module en particulier, précise son nom complet et sa norme associée.

|

||||

- Fais attention aux messages d'erreur qui peuvent apparaître en bas ou en haut de l'écran.

|

||||

|

||||

Fournis une analyse STRICTEMENT FACTUELLE de l'image avec les sections suivantes:

|

||||

{self.instructions_analyse}"""

|

||||

|

||||

def executer(self, image_path: str, contexte: str) -> Dict[str, Any]:

|

||||

def executer(self, image_path: str, contexte: str = "") -> Dict[str, Any]:

|

||||

"""

|

||||

Analyse une image en tenant compte du contexte du ticket

|

||||

|

||||

Args:

|

||||

image_path: Chemin vers l'image à analyser

|

||||

contexte: Contexte du ticket (résultat de l'analyse JSON)

|

||||

|

||||

Returns:

|

||||

Dictionnaire contenant l'analyse détaillée de l'image et les métadonnées d'exécution

|

||||

"""

|

||||

image_name = os.path.basename(image_path)

|

||||

logger.info(f"Analyse de l'image: {image_name} avec contexte")

|

||||

print(f" AgentImageAnalyser: Analyse de {image_name}")

|

||||

|

||||

# Vérifier que l'image existe et est accessible

|

||||

if not self._verifier_image(image_path):

|

||||

error_message = f"L'image n'est pas accessible ou n'est pas valide: {image_name}"

|

||||

logger.error(error_message)

|

||||

print(f" ERREUR: {error_message}")

|

||||

return self._erreur("Erreur d'accès ou image invalide", image_path)

|

||||

|

||||

return {

|

||||

"analyse": f"ERREUR: {error_message}. Veuillez vérifier que l'image existe et est valide.",

|

||||

"error": True,

|

||||

"metadata": {

|

||||

"image_path": image_path,

|

||||

"image_name": image_name,

|

||||

"timestamp": self._get_timestamp(),

|

||||

"error": True

|

||||

}

|

||||

}

|

||||

|

||||

# Générer le prompt d'analyse avec les instructions centralisées

|

||||

prompt = self._generer_prompt_analyse(contexte, "Analyse cette image en tenant compte du contexte suivant:")

|

||||

|

||||

try:

|

||||

logger.info("Envoi de la requête au LLM")

|

||||

prompt = self._generer_prompt_analyse(contexte, "Analyse cette image en tenant compte du contexte suivant:")

|

||||

|

||||

# Utiliser la méthode interroger_avec_image au lieu de interroger

|

||||

if hasattr(self.llm, "interroger_avec_image"):

|

||||

logger.info(f"Utilisation de la méthode interroger_avec_image pour {image_name}")

|

||||

response = self.llm.interroger_avec_image(image_path, prompt)

|

||||

else:

|

||||

# Fallback vers la méthode standard avec base64 si interroger_avec_image n'existe pas

|

||||

logger.warning(f"La méthode interroger_avec_image n'existe pas, utilisation du fallback pour {image_name}")

|

||||

img_base64 = self._encoder_image_base64(image_path)

|

||||

elif hasattr(self.llm, "_encoder_image_base64"):

|

||||

img_base64 = self.llm._encoder_image_base64(image_path)

|

||||

if img_base64:

|

||||

# Utiliser le même générateur de prompt avec l'image en base64

|

||||

prompt_base64 = self._generer_prompt_analyse(contexte, f"Analyse cette image:\n{img_base64}")

|

||||

|

||||

response = self.llm.interroger(prompt_base64)

|

||||

else:

|

||||

error_message = "Impossible d'encoder l'image en base64"

|

||||

logger.error(f"Erreur d'analyse pour {image_name}: {error_message}")

|

||||

print(f" ERREUR: {error_message}")

|

||||

|

||||

# Retourner un résultat d'erreur explicite

|

||||

return {

|

||||

"analyse": f"ERREUR: {error_message}. Veuillez vérifier que l'image est dans un format standard.",

|

||||

"error": True,

|

||||

"raw_response": "",

|

||||

"metadata": {

|

||||

"image_path": image_path,

|

||||

"image_name": image_name,

|

||||

"timestamp": self._get_timestamp(),

|

||||

"error": True

|

||||

}

|

||||

}

|

||||

return self._erreur("Impossible d'encoder l'image en base64", image_path)

|

||||

else:

|

||||

return self._erreur("Le modèle ne supporte pas l'analyse d'images", image_path)

|

||||

|

||||

# Vérifier si la réponse contient des indications que le modèle ne peut pas analyser l'image

|

||||

error_phrases = [

|

||||

@ -268,71 +186,74 @@ Fournis une analyse STRICTEMENT FACTUELLE de l'image avec les sections suivantes

|

||||

"erreur: impossible d'analyser l'image"

|

||||

]

|

||||

|

||||

# Vérifier si une des phrases d'erreur est présente dans la réponse

|

||||

if any(phrase in response.lower() for phrase in error_phrases):

|

||||

logger.warning(f"Le modèle indique qu'il ne peut pas analyser l'image: {image_name}")

|

||||

error_message = "Le modèle n'a pas pu analyser l'image correctement"

|

||||

logger.error(f"Erreur d'analyse pour {image_name}: {error_message}")

|

||||

print(f" ERREUR: {error_message}")

|

||||

|

||||

# Retourner un résultat d'erreur explicite

|

||||

return {

|

||||

"analyse": f"ERREUR: {error_message}. Veuillez vérifier que le modèle a accès à l'image ou utiliser un modèle différent.",

|

||||

"error": True,

|

||||

"raw_response": response,

|

||||

"metadata": {

|

||||

"image_path": image_path,

|

||||

"image_name": image_name,

|

||||

"timestamp": self._get_timestamp(),

|

||||

"error": True

|

||||

}

|

||||

}

|

||||

return self._erreur("Le modèle n'a pas pu analyser l'image correctement", image_path, raw=response)

|

||||

|

||||

logger.info(f"Réponse reçue pour l'image {image_name}: {response[:100]}...")

|

||||

# Effectuer des corrections sur la réponse si nécessaire

|

||||

response = self._corriger_termes_courants(response)

|

||||

|

||||

# Créer un dictionnaire de résultat avec l'analyse et les métadonnées

|

||||

result = {

|

||||

"analyse": response,

|

||||

"raw_response": response,

|

||||

"metadata": {

|

||||

"image_path": image_path,

|

||||

"image_name": image_name,

|

||||

"timestamp": self._get_timestamp(),

|

||||

"model_info": {

|

||||

"model": getattr(self.llm, "modele", str(type(self.llm))),

|

||||

"temperature": self.temperature,

|

||||

"top_p": self.top_p,

|

||||

"max_tokens": self.max_tokens

|

||||

}

|

||||

**getattr(self.llm, "params", {})

|

||||

},

|

||||

"source_agent": self.nom

|

||||

}

|

||||

}

|

||||

|

||||

# Enregistrer l'analyse dans l'historique avec contexte et prompt

|

||||

self.ajouter_historique("analyse_image",

|

||||

{

|

||||

"image_path": image_path,

|

||||

"contexte": contexte,

|

||||

"prompt": prompt

|

||||

},

|

||||

response)

|

||||

# Sauvegarder les données dans le fichier

|

||||

sauvegarder_donnees(None, "analyse_image", result, base_dir="reports", is_resultat=True)

|

||||

|

||||

# Enregistrer l'analyse dans l'historique

|

||||

self.ajouter_historique(

|

||||

"analyse_image",

|

||||

{"image_path": image_path, "contexte": contexte, "prompt": prompt},

|

||||

result

|

||||

)

|

||||

|

||||

return result

|

||||

|

||||

except Exception as e:

|

||||

error_message = f"Erreur lors de l'analyse de l'image: {str(e)}"

|

||||

logger.error(error_message)

|

||||

print(f" ERREUR: {error_message}")

|

||||

return self._erreur(str(e), image_path)

|

||||

|

||||

def _corriger_termes_courants(self, texte: str) -> str:

|

||||

"""

|

||||

Corrige certains termes couramment mal interprétés par le modèle.

|

||||

"""

|

||||

corrections = {

|

||||

"PAZ": "RAZ",

|

||||

"Essai bleu": "Essai au bleu de méthylène",

|

||||

"essai bleu": "essai au bleu de méthylène",

|

||||

"Essai au bleu": "Essai au bleu de méthylène"

|

||||

}

|

||||

|

||||

for terme_incorrect, terme_correct in corrections.items():

|

||||

texte = texte.replace(terme_incorrect, terme_correct)

|

||||

|

||||

# Retourner un résultat par défaut en cas d'erreur

|

||||

return {

|

||||

"analyse": f"ERREUR: {error_message}",

|

||||

return texte

|

||||

|

||||

def _erreur(self, message: str, path: str, raw: str = "") -> Dict[str, Any]:

|

||||

"""

|

||||

Crée un dictionnaire de réponse en cas d'erreur

|

||||

"""

|

||||

return {

|

||||

"analyse": f"ERREUR: {message}",

|

||||

"raw_response": raw,

|

||||

"error": True,

|

||||

"metadata": {

|

||||

"image_path": path,

|

||||

"image_name": os.path.basename(path),

|

||||

"timestamp": self._get_timestamp(),

|

||||

"error": True,

|

||||

"metadata": {

|

||||

"image_path": image_path,

|

||||

"image_name": image_name,

|

||||

"timestamp": self._get_timestamp(),

|

||||

"error": True

|

||||

}

|

||||

"source_agent": self.nom

|

||||

}

|

||||

}

|

||||

|

||||

def _get_timestamp(self) -> str:

|

||||

"""Retourne un timestamp au format YYYYMMDD_HHMMSS"""

|

||||

|

||||

@ -3,8 +3,7 @@ import logging

|

||||

import os

|

||||

from typing import Dict, Any, Tuple

|

||||

from PIL import Image

|

||||

import base64

|

||||

import io

|

||||

from ..utils.pipeline_logger import sauvegarder_donnees

|

||||

|

||||

logger = logging.getLogger("AgentImageSorter")

|

||||

|

||||

@ -14,262 +13,104 @@ class AgentImageSorter(BaseAgent):

|

||||

"""

|

||||

def __init__(self, llm):

|

||||

super().__init__("AgentImageSorter", llm)

|

||||

|

||||

# Configuration locale de l'agent

|

||||

self.temperature = 0.2

|

||||

self.top_p = 0.8

|

||||

self.max_tokens = 300

|

||||

|

||||

# Centralisation des critères de pertinence

|

||||

self.criteres_pertinence = """

|

||||

Images PERTINENTES (réponds "oui" ou "pertinent"):

|

||||

- Captures d'écran de logiciels ou d'interfaces

|

||||

- logo BRG_LAB

|

||||

- Référence à "logociel"

|

||||

- Messages d'erreur

|

||||

- Configurations système

|

||||

- Tableaux de bord ou graphiques techniques

|

||||

- Fenêtres de diagnostic

|

||||

|

||||

Images NON PERTINENTES (réponds "non" ou "non pertinent"):

|

||||

- Photos personnelles

|

||||

- Images marketing/promotionnelles

|

||||

- Logos ou images de marque

|

||||

- Paysages, personnes ou objets non liés à l'informatique

|

||||

"""

|

||||

# Configuration centralisée dans un dictionnaire

|

||||

self.params = {

|

||||

"temperature": 0.2,

|

||||

"top_p": 0.8,

|

||||

"max_tokens": 300

|

||||

# Ajoutez facilement d'autres paramètres ici sans modifier _appliquer_config_locale

|

||||

}

|

||||

|

||||

# Centralisation des instructions d'analyse

|

||||

self.instructions_analyse = """

|

||||

IMPORTANT: Ne commence JAMAIS ta réponse par "Je ne peux pas directement visualiser l'image".

|

||||

Si tu ne peux pas analyser l'image, réponds simplement "ERREUR: Impossible d'analyser l'image".

|

||||

self.criteres_pertinence = (

|

||||

"""

|

||||

Images PERTINENTES (réponds "oui" ou "pertinent"):

|

||||

- Captures d'écran de logiciels ou d'interfaces

|

||||

- logo BRG_LAB

|

||||

- Référence à "logociel"

|

||||

- Messages d'erreur

|

||||

- Configurations système

|

||||

- Tableaux de bord ou graphiques techniques

|

||||

- Fenêtres de diagnostic

|

||||

|

||||

Analyse d'abord ce que montre l'image, puis réponds par "oui"/"pertinent" ou "non"/"non pertinent".

|

||||

"""

|

||||

Images NON PERTINENTES (réponds "non" ou "non pertinent"):

|

||||

- Photos personnelles

|

||||

- Images marketing/promotionnelles

|

||||

- Logos ou images de marque

|

||||

- Paysages, personnes ou objets non liés à l'informatique

|

||||

"""

|

||||

)

|

||||

|

||||

self.instructions_analyse = (

|

||||

"""

|

||||

IMPORTANT: Ne commence JAMAIS ta réponse par "Je ne peux pas directement visualiser l'image".

|

||||

Si tu ne peux pas analyser l'image, réponds simplement "ERREUR: Impossible d'analyser l'image".

|

||||

|

||||

Analyse d'abord ce que montre l'image, puis réponds par "oui"/"pertinent" ou "non"/"non pertinent".

|

||||

"""

|

||||

)

|

||||

|

||||

self.system_prompt = (

|

||||

"""

|

||||

Tu es un expert en tri d'images pour le support technique de BRG_Lab pour la société CBAO.

|

||||

Ta mission est de déterminer si une image est pertinente pour le support technique de logiciels.

|

||||

{criteres}

|

||||

{instructions}

|

||||

"""

|

||||

).format(

|

||||

criteres=self.criteres_pertinence,

|

||||

instructions=self.instructions_analyse

|

||||

)

|

||||

|

||||

# Construction du système prompt à partir des éléments centralisés

|

||||

self.system_prompt = f"""Tu es un expert en tri d'images pour le support technique de BRG_Lab pour la société CBAO.

|

||||

Ta mission est de déterminer si une image est pertinente pour le support technique de logiciels.

|

||||

{self.criteres_pertinence}

|

||||

{self.instructions_analyse}"""

|

||||

|

||||

# Appliquer la configuration au LLM

|

||||

self._appliquer_config_locale()

|

||||

|

||||

logger.info("AgentImageSorter initialisé")

|

||||

|

||||

|

||||

def _appliquer_config_locale(self) -> None:

|

||||

"""

|

||||

Applique la configuration locale au modèle LLM.

|

||||

"""

|

||||

# Appliquer le prompt système

|

||||

if hasattr(self.llm, "prompt_system"):

|

||||

self.llm.prompt_system = self.system_prompt

|

||||

|

||||

# Appliquer les paramètres

|

||||

if hasattr(self.llm, "configurer"):

|

||||

params = {

|

||||

"temperature": self.temperature,

|

||||

"top_p": self.top_p,

|

||||

"max_tokens": self.max_tokens

|

||||

}

|

||||

|

||||

self.llm.configurer(**params)

|

||||

|

||||

def _verifier_image(self, image_path: str) -> bool:

|

||||

"""

|

||||

Vérifie si l'image existe et est accessible

|

||||

|

||||

Args:

|

||||

image_path: Chemin vers l'image

|

||||

|

||||

Returns:

|

||||

True si l'image existe et est accessible, False sinon

|

||||

"""

|

||||

try:

|

||||

# Vérifier que le fichier existe

|

||||

if not os.path.exists(image_path):

|

||||

logger.error(f"L'image n'existe pas: {image_path}")

|

||||

return False

|

||||

|

||||

# Vérifier que le fichier est accessible en lecture

|

||||

if not os.access(image_path, os.R_OK):

|

||||

logger.error(f"L'image n'est pas accessible en lecture: {image_path}")

|

||||

return False

|

||||

|

||||

# Vérifier que le fichier peut être ouvert comme une image

|

||||

with Image.open(image_path) as img:

|

||||

# Vérifier les dimensions de l'image

|

||||

width, height = img.size

|

||||

if width <= 0 or height <= 0:

|

||||

logger.error(f"Dimensions d'image invalides: {width}x{height}")

|

||||

return False

|

||||

|

||||

logger.info(f"Image vérifiée avec succès: {image_path} ({width}x{height})")

|

||||

return True

|

||||

except Exception as e:

|

||||

logger.error(f"Erreur lors de la vérification de l'image {image_path}: {str(e)}")

|

||||

return False

|

||||

|

||||

def _encoder_image_base64(self, image_path: str) -> str:

|

||||

"""

|

||||

Encode l'image en base64 pour l'inclure directement dans le prompt

|

||||

|

||||

Args:

|

||||

image_path: Chemin vers l'image

|

||||

|

||||

Returns:

|

||||

Chaîne de caractères au format data URI avec l'image encodée en base64

|

||||

"""

|

||||

try:

|

||||

# Ouvrir l'image et la redimensionner si trop grande

|

||||

with Image.open(image_path) as img:

|

||||

# Redimensionner l'image si elle est trop grande (max 800x800)

|

||||

max_size = 800

|

||||

if img.width > max_size or img.height > max_size:

|

||||

img.thumbnail((max_size, max_size), Image.Resampling.LANCZOS)

|

||||

|

||||

# Convertir en RGB si nécessaire (pour les formats comme PNG)

|

||||

if img.mode != "RGB":

|

||||

img = img.convert("RGB")

|

||||

|

||||

# Sauvegarder l'image en JPEG dans un buffer mémoire

|

||||

buffer = io.BytesIO()

|

||||

img.save(buffer, format="JPEG", quality=85)

|

||||

buffer.seek(0)

|

||||

|

||||

# Encoder en base64

|

||||

img_base64 = base64.b64encode(buffer.read()).decode("utf-8")

|

||||

|

||||

# Construire le data URI

|

||||

data_uri = f"data:image/jpeg;base64,{img_base64}"

|

||||

|

||||

return data_uri

|

||||

except Exception as e:

|

||||

logger.error(f"Erreur lors de l'encodage de l'image {image_path}: {str(e)}")

|

||||

return ""

|

||||

|

||||

def _generer_prompt_analyse(self, prefix: str = "", avec_image_base64: bool = False) -> str:

|

||||

"""

|

||||

Génère le prompt d'analyse standardisé

|

||||

|

||||

Args:

|

||||

prefix: Préfixe optionnel (pour inclure l'image en base64 par exemple)

|

||||

avec_image_base64: Indique si le prompt inclut déjà une image en base64

|

||||

|

||||

Returns:

|

||||

Prompt formaté pour l'analyse

|

||||

"""

|

||||

return f"""{prefix}

|

||||

# Utiliser directement le dictionnaire de paramètres

|

||||

self.llm.configurer(**self.params)

|

||||

|

||||

def _verifier_image(self, image_path: str) -> bool:

|

||||

try:

|

||||

if not os.path.exists(image_path) or not os.access(image_path, os.R_OK):

|

||||

return False

|

||||

with Image.open(image_path) as img:

|

||||

width, height = img.size

|

||||

return width > 0 and height > 0

|

||||

except Exception as e:

|

||||

logger.error(f"Vérification impossible pour {image_path}: {e}")

|

||||

return False

|

||||

|

||||

def _generer_prompt_analyse(self, prefix: str = "") -> str:

|

||||

return f"{prefix}\n\nEst-ce une image pertinente pour un ticket de support technique?\nRéponds simplement par 'oui' ou 'non' suivi d'une brève explication."

|

||||

|

||||

def executer(self, image_path: str) -> Dict[str, Any]:

|

||||

image_name = os.path.basename(image_path)

|

||||

print(f" AgentImageSorter: Évaluation de {image_name}")

|

||||

|

||||

if not self._verifier_image(image_path):

|

||||

return self._erreur("Erreur d'accès ou image invalide", image_path)

|

||||

|

||||

Est-ce une image pertinente pour un ticket de support technique?

|

||||

Réponds simplement par 'oui' ou 'non' suivi d'une brève explication."""

|

||||

|

||||

def executer(self, image_path: str) -> Dict[str, Any]:

|

||||

"""

|

||||

Évalue si une image est pertinente pour l'analyse d'un ticket technique

|

||||

|

||||

Args:

|

||||

image_path: Chemin vers l'image à analyser

|

||||

|

||||

Returns:

|

||||

Dictionnaire contenant la décision de pertinence, l'analyse et les métadonnées

|

||||

"""

|

||||

image_name = os.path.basename(image_path)

|

||||

logger.info(f"Évaluation de la pertinence de l'image: {image_name}")

|

||||

print(f" AgentImageSorter: Évaluation de {image_name}")

|

||||

|

||||

# Vérifier que l'image existe et est accessible

|

||||

if not self._verifier_image(image_path):

|

||||

error_message = f"L'image n'est pas accessible ou n'est pas valide: {image_name}"

|

||||

logger.error(error_message)

|

||||

print(f" ERREUR: {error_message}")

|

||||

|

||||

return {

|

||||

"is_relevant": False,

|

||||

"reason": f"Erreur d'accès: {error_message}",

|

||||

"raw_response": "",

|

||||

"error": True,

|

||||

"metadata": {

|

||||

"image_path": image_path,

|

||||

"image_name": image_name,

|

||||

"timestamp": self._get_timestamp(),

|

||||

"error": True

|

||||

}

|

||||

}

|

||||

|

||||

# Utiliser une référence au fichier image que le modèle peut comprendre

|

||||

try:

|

||||

# Préparation du prompt standardisé

|

||||

prompt = self._generer_prompt_analyse()

|

||||

|

||||

# Utiliser la méthode interroger_avec_image au lieu de interroger

|

||||

if hasattr(self.llm, "interroger_avec_image"):

|

||||

logger.info(f"Utilisation de la méthode interroger_avec_image pour {image_name}")

|

||||

response = self.llm.interroger_avec_image(image_path, prompt)

|

||||

elif hasattr(self.llm, "_encoder_image_base64"):

|

||||

img_base64 = self.llm._encoder_image_base64(image_path)

|

||||

prompt = self._generer_prompt_analyse(f"Analyse cette image:\n{img_base64}")

|

||||

response = self.llm.interroger(prompt)

|

||||

else:

|

||||

# Fallback vers la méthode standard avec base64 si interroger_avec_image n'existe pas

|

||||

logger.warning(f"La méthode interroger_avec_image n'existe pas, utilisation du fallback pour {image_name}")

|

||||

img_base64 = self._encoder_image_base64(image_path)

|

||||

if img_base64:

|

||||

prompt_base64 = self._generer_prompt_analyse(f"Analyse cette image:\n{img_base64}", True)

|

||||

response = self.llm.interroger(prompt_base64)

|

||||

else:

|

||||

error_message = "Impossible d'encoder l'image en base64"

|

||||

logger.error(f"Erreur d'analyse pour {image_name}: {error_message}")

|

||||

print(f" ERREUR: {error_message}")

|

||||

|

||||

return {

|

||||

"is_relevant": False,

|

||||

"reason": f"Erreur d'analyse: {error_message}",

|

||||

"raw_response": "",

|

||||

"error": True,

|

||||

"metadata": {

|

||||

"image_path": image_path,

|

||||

"image_name": image_name,

|

||||

"timestamp": self._get_timestamp(),

|

||||

"error": True

|

||||

}

|

||||

}

|

||||

|

||||

# Vérifier si la réponse contient des indications que le modèle ne peut pas analyser l'image

|

||||

error_phrases = [

|

||||

"je ne peux pas directement visualiser",

|

||||

"je n'ai pas accès à l'image",

|

||||

"je ne peux pas voir l'image",

|

||||

"sans accès direct à l'image",

|

||||

"je n'ai pas la possibilité de voir",

|

||||

"je ne peux pas accéder directement",

|

||||

"erreur: impossible d'analyser l'image"

|

||||

]

|

||||

|

||||

# Vérifier si une des phrases d'erreur est présente dans la réponse

|

||||

if any(phrase in response.lower() for phrase in error_phrases):

|

||||

logger.warning(f"Le modèle indique qu'il ne peut pas analyser l'image: {image_name}")

|

||||

error_message = "Le modèle n'a pas pu analyser l'image correctement"

|

||||

logger.error(f"Erreur d'analyse pour {image_name}: {error_message}")

|

||||

print(f" ERREUR: {error_message}")

|

||||

|

||||

# Retourner un résultat d'erreur explicite

|

||||

return {

|

||||

"is_relevant": False,

|

||||

"reason": f"Erreur d'analyse: {error_message}",

|

||||

"raw_response": response,

|

||||

"error": True,

|

||||

"metadata": {

|

||||

"image_path": image_path,

|

||||

"image_name": image_name,

|

||||

"timestamp": self._get_timestamp(),

|

||||

"error": True

|

||||

}

|

||||

}

|

||||

|

||||

# Analyse de la réponse pour déterminer la pertinence

|

||||

return self._erreur("Le modèle ne supporte pas les images", image_path)

|

||||

|

||||

if any(err in response.lower() for err in [

|

||||

"je ne peux pas", "je n'ai pas accès", "impossible d'analyser"]):

|

||||

return self._erreur("Réponse du modèle invalide", image_path, raw=response)

|

||||

|

||||

is_relevant, reason = self._analyser_reponse(response)

|

||||

|

||||

logger.info(f"Image {image_name} considérée comme {'pertinente' if is_relevant else 'non pertinente'}")

|

||||

print(f" Décision: Image {image_name} {'pertinente' if is_relevant else 'non pertinente'}")

|

||||

|

||||

# Préparer le résultat

|

||||

|

||||

result = {

|

||||

"is_relevant": is_relevant,

|

||||

"reason": reason,

|

||||

@ -280,114 +121,49 @@ Réponds simplement par 'oui' ou 'non' suivi d'une brève explication."""

|

||||

"timestamp": self._get_timestamp(),

|

||||

"model_info": {

|

||||

"model": getattr(self.llm, "modele", str(type(self.llm))),

|

||||

"temperature": self.temperature,

|

||||

"top_p": self.top_p,

|

||||

"max_tokens": self.max_tokens

|

||||

}

|

||||

**getattr(self.llm, "params", {})

|

||||

},

|

||||

"source_agent": self.nom

|

||||

}

|

||||

}

|

||||

|

||||

# Enregistrer la décision et le raisonnement dans l'historique

|

||||

self.ajouter_historique("tri_image",

|

||||

{

|

||||

"image_path": image_path,

|

||||

"prompt": prompt

|

||||

},

|

||||

{

|

||||

"response": response,

|

||||

"is_relevant": is_relevant,

|

||||

"reason": reason

|

||||

})

|

||||

|

||||

# Sauvegarder les données dans le fichier

|

||||

sauvegarder_donnees(None, "tri_image", result, base_dir="reports", is_resultat=True)

|

||||

|

||||

self.ajouter_historique("tri_image", {"image_path": image_path, "prompt": prompt}, result)

|

||||

return result

|

||||

|

||||

|

||||

except Exception as e:

|

||||

logger.error(f"Erreur lors de l'analyse de l'image {image_name}: {str(e)}")

|

||||

print(f" ERREUR: Impossible d'analyser l'image {image_name}")

|

||||

|

||||

# Retourner un résultat par défaut en cas d'erreur

|

||||

return {

|

||||

"is_relevant": False, # Par défaut, considérer non pertinent en cas d'erreur

|

||||

"reason": f"Erreur d'analyse: {str(e)}",

|

||||

"raw_response": "",

|

||||

"error": True,

|

||||

"metadata": {

|

||||

"image_path": image_path,

|

||||

"image_name": image_name,

|

||||

"timestamp": self._get_timestamp(),

|

||||

"error": True

|

||||

}

|

||||

}

|

||||

|

||||

return self._erreur(str(e), image_path)

|

||||

|

||||

def _analyser_reponse(self, response: str) -> Tuple[bool, str]:

|

||||

"""

|

||||

Analyse la réponse du LLM pour déterminer la pertinence et extraire le raisonnement

|

||||

|

||||

Args:

|

||||

response: Réponse brute du LLM

|

||||

|

||||

Returns:

|

||||

Tuple (is_relevant, reason) contenant la décision et le raisonnement

|

||||

"""

|

||||

# Convertir en minuscule pour faciliter la comparaison

|

||||

response_lower = response.lower()

|

||||

|

||||

# Détection directe des réponses négatives en début de texte

|

||||

first_line = response_lower.split('\n')[0] if '\n' in response_lower else response_lower[:50]

|

||||

starts_with_non = first_line.strip().startswith("non") or first_line.strip().startswith("non.")

|

||||

|

||||

# Détection explicite d'une réponse négative au début de la réponse

|

||||

explicit_negative = starts_with_non or any(neg_start in first_line for neg_start in ["non pertinent", "pas pertinent"])

|

||||

|

||||

# Détection explicite d'une réponse positive au début de la réponse

|

||||

explicit_positive = first_line.strip().startswith("oui") or first_line.strip().startswith("pertinent")

|

||||

|

||||

# Si une réponse explicite est détectée, l'utiliser directement

|

||||

if explicit_negative:

|

||||

is_relevant = False

|

||||

elif explicit_positive:

|

||||

is_relevant = True

|

||||

else:

|

||||

# Sinon, utiliser l'analyse par mots-clés

|

||||

# Mots clés positifs forts

|

||||

positive_keywords = ["oui", "pertinent", "pertinente", "utile", "important", "relevante",

|

||||

"capture d'écran", "message d'erreur", "interface logicielle",

|

||||

"configuration", "technique", "diagnostic"]

|

||||

|

||||

# Mots clés négatifs forts

|

||||

negative_keywords = ["non", "pas pertinent", "non pertinente", "inutile", "irrelevant",

|

||||

"photo personnelle", "marketing", "sans rapport", "hors sujet",

|

||||

"décorative", "logo"]

|

||||

|

||||

# Compter les occurrences de mots clés

|

||||

positive_count = sum(1 for kw in positive_keywords if kw in response_lower)

|

||||

negative_count = sum(1 for kw in negative_keywords if kw in response_lower)

|

||||

|

||||

# Heuristique de décision basée sur la prépondérance des mots clés

|

||||

is_relevant = positive_count > negative_count

|

||||

|

||||

# Extraire le raisonnement (les dernières phrases de la réponse)

|

||||

lines = response.split('\n')

|

||||

reason_lines = []

|

||||

for line in reversed(lines):

|

||||

if line.strip():

|

||||

reason_lines.insert(0, line.strip())

|

||||

if len(reason_lines) >= 2: # Prendre les 2 dernières lignes non vides

|

||||

break

|

||||

|

||||

reason = " ".join(reason_lines) if reason_lines else "Décision basée sur l'analyse des mots-clés"

|

||||

|

||||

# Log détaillé de l'analyse

|

||||

logger.debug(f"Analyse de la réponse: \n - Réponse brute: {response[:100]}...\n"

|

||||

f" - Commence par 'non': {starts_with_non}\n"

|

||||

f" - Détection explicite négative: {explicit_negative}\n"

|

||||

f" - Détection explicite positive: {explicit_positive}\n"

|

||||

f" - Décision finale: {'pertinente' if is_relevant else 'non pertinente'}\n"

|

||||

f" - Raison: {reason}")

|

||||

|

||||

return is_relevant, reason

|

||||

|

||||

r = response.lower()

|

||||

first_line = r.split('\n')[0] if '\n' in r else r[:50].strip()

|

||||

if first_line.startswith("non") or "non pertinent" in first_line:

|

||||

return False, response.strip()

|

||||

if first_line.startswith("oui") or "pertinent" in first_line:

|

||||

return True, response.strip()

|

||||

|

||||

pos_keywords = ["pertinent", "utile", "important", "diagnostic"]

|

||||

neg_keywords = ["inutile", "photo", "hors sujet", "marketing", "non pertinent"]

|

||||

score = sum(kw in r for kw in pos_keywords) - sum(kw in r for kw in neg_keywords)

|

||||

return score > 0, response.strip()

|

||||

|

||||

def _erreur(self, message: str, path: str, raw: str = "") -> Dict[str, Any]:

|

||||

return {

|

||||

"is_relevant": False,

|

||||

"reason": message,

|

||||

"raw_response": raw,

|

||||

"error": True,

|

||||

"metadata": {

|

||||

"image_path": path,

|

||||

"image_name": os.path.basename(path),

|

||||

"timestamp": self._get_timestamp(),

|

||||

"error": True,

|

||||

"source_agent": self.nom

|

||||

}

|

||||

}

|

||||

|

||||

def _get_timestamp(self) -> str:

|

||||

"""Retourne un timestamp au format YYYYMMDD_HHMMSS"""

|

||||

from datetime import datetime

|

||||

return datetime.now().strftime("%Y%m%d_%H%M%S")

|

||||

@ -1,609 +1,272 @@

|

||||

import json

|

||||

import os

|

||||

from ..base_agent import BaseAgent

|

||||

from datetime import datetime

|

||||

from typing import Dict, Any, Tuple, Optional, List

|

||||

from typing import Dict, Any

|

||||

import logging

|

||||

import os

|

||||

import json

|

||||

import traceback

|

||||

import re

|

||||

import sys

|

||||

from ..utils.report_utils import extraire_et_traiter_json

|

||||

from ..utils.report_formatter import extraire_sections_texte, generer_rapport_markdown, construire_rapport_json

|

||||

from ..utils.agent_info_collector import collecter_info_agents, collecter_prompts_agents

|

||||

from datetime import datetime

|

||||

from ..utils.pipeline_logger import sauvegarder_donnees

|

||||

|

||||

logger = logging.getLogger("AgentReportGeneratorQwen")

|

||||

# Configuration du logger pour plus de détails

|

||||

logger = logging.getLogger("AgentReportGenerator")

|

||||

logger.setLevel(logging.DEBUG) # Augmenter le niveau de logging pour le débogage

|

||||

|

||||

class AgentReportGenerator(BaseAgent):

|

||||

"""

|

||||

Agent spécialisé pour générer des rapports avec le modèle Qwen.

|

||||

Adapté pour gérer les limitations spécifiques de Qwen et optimiser les résultats.

|

||||

|

||||

Cet agent utilise une approche en plusieurs étapes pour éviter les timeouts

|

||||

et s'assurer que tous les éléments du rapport soient bien générés.

|

||||

"""

|

||||

def __init__(self, llm):

|

||||

super().__init__("AgentReportGeneratorQwen", llm)

|

||||

|

||||

# Configuration locale de l'agent

|

||||

self.temperature = 0.2

|

||||

self.top_p = 0.9

|

||||

self.max_tokens = 10000 # Réduit pour Qwen pour éviter les timeouts

|

||||

|

||||

# Prompt système principal - Simplifié et optimisé pour Qwen

|

||||

self.system_prompt = """Tu es un expert en génération de rapports techniques pour BRG-Lab.

|

||||

Ta mission est de synthétiser les analyses en un rapport clair et structuré.

|

||||

super().__init__("AgentReportGenerator", llm)

|

||||

|

||||

TON RAPPORT DOIT OBLIGATOIREMENT INCLURE DANS CET ORDRE:

|

||||

1. Un résumé du problème initial

|

||||

2. Une analyse des images pertinentes (courte)

|

||||

3. Une synthèse globale des analyses d'images (très brève)

|

||||

4. Une reconstitution du fil de discussion

|

||||

5. Un tableau des échanges au format JSON

|

||||

6. Un diagnostic technique des causes probables

|

||||

self.params = {

|

||||

"temperature": 0.2,

|

||||

"top_p": 0.8,

|

||||

"max_tokens": 8000

|

||||

}

|

||||

|

||||

Le format JSON des échanges DOIT être exactement:

|

||||

```json

|

||||

{

|

||||

"chronologie_echanges": [

|

||||

{"date": "date exacte", "emetteur": "CLIENT", "type": "Question", "contenu": "contenu synthétisé"},

|

||||

{"date": "date exacte", "emetteur": "SUPPORT", "type": "Réponse", "contenu": "contenu avec liens"}

|

||||

]

|

||||

}

|

||||

```

|

||||

self.system_prompt = """Tu es un expert en support technique chargé de générer un rapport final à partir des analyses d'un ticket de support.

|

||||

Ton rôle est de croiser les informations provenant :

|

||||

- de l'analyse textuelle du ticket client

|

||||

- des analyses détaillées de plusieurs captures d'écran

|

||||

|

||||

Tu dois structurer ta réponse en format question/réponse de manière claire, en gardant l'intégralité des points importants.

|

||||

|

||||

Ne propose jamais de solution. Ne reformule pas le contexte.

|

||||

Ta seule mission est de croiser les données textuelles et visuelles et d'en tirer des observations claires, en listant les éléments factuels visibles dans les captures qui appuient ou complètent le texte du ticket.

|

||||

|

||||

Structure du rapport attendu :

|

||||

1. Contexte général (résumé du ticket textuel en une phrase)

|

||||

2. Problèmes ou questions identifiés (sous forme de questions claires)

|

||||

3. Résumé croisé image/texte pour chaque question

|

||||

4. Liste d'observations supplémentaires pertinentes (si applicable)

|

||||

5. Tableau chronologique d'échanges

|

||||

- Inclure un tableau structuré des échanges entre client et support

|

||||

- Format : Émetteur | Type | Date | Contenu | Éléments visuels pertinents

|

||||

- Ne pas mentionner les noms réels des personnes, utiliser "CLIENT" et "SUPPORT"

|

||||

- Synthétiser le contenu tout en conservant les informations importantes

|

||||

- Associer les éléments visuels des captures d'écran aux échanges correspondants

|

||||

|

||||

Règles pour le tableau d'échanges :

|

||||

- TYPE peut être : question, réponse, information, complément visuel

|

||||

- Pour chaque échange du client mentionnant un problème, ajoute les éléments visuels des captures qui contextualisent ce problème

|

||||

- Pour chaque réponse du support, ajoute les éléments visuels qui confirment ou infirment la réponse

|

||||

- N'invente aucun contenu ni aucune date

|

||||

- Utilise les données factuelles des images pour enrichir la compréhension des échanges

|

||||

|

||||

Reste strictement factuel. Ne fais aucune hypothèse. Ne suggère pas d'étapes ni d'interprétation."""

|

||||

|

||||

IMPORTANT: La structure JSON correcte est la partie la plus critique!"""

|

||||

|

||||

# Version du prompt pour la traçabilité

|

||||

self.prompt_version = "qwen-v1.1"

|

||||

|

||||

# Flag pour indiquer si on doit utiliser l'approche en 2 étapes

|

||||

self.use_two_step_approach = True

|

||||

|

||||

# Appliquer la configuration au LLM

|

||||

self._appliquer_config_locale()

|

||||

|

||||

logger.info("AgentReportGeneratorQwen initialisé")

|

||||

|

||||

logger.info("AgentReportGenerator initialisé")

|

||||

|

||||

def _appliquer_config_locale(self) -> None:

|

||||

"""

|

||||

Applique la configuration locale au modèle LLM.

|

||||

"""

|

||||

# Appliquer le prompt système

|

||||

if hasattr(self.llm, "prompt_system"):

|

||||

self.llm.prompt_system = self.system_prompt

|

||||

|

||||

# Appliquer les paramètres

|

||||

if hasattr(self.llm, "configurer"):

|

||||

params = {

|

||||

"temperature": self.temperature,

|

||||

"top_p": self.top_p,

|

||||

"max_tokens": self.max_tokens,

|

||||

"timeout": 60 # Timeout réduit pour Qwen

|

||||

}

|

||||

self.llm.configurer(**params)

|

||||

logger.info(f"Configuration appliquée au modèle Qwen: {str(params)}")

|

||||

|

||||

def _formater_prompt_pour_rapport_etape1(self, ticket_analyse: str, images_analyses: List[Dict]) -> str:

|

||||

self.llm.configurer(**self.params)

|

||||

|

||||

def _verifier_donnees_entree(self, rapport_data: Dict[str, Any]) -> bool:

|

||||

"""

|

||||

Formate le prompt pour la première étape: résumé, analyse d'images et synthèse

|

||||

Vérifie que les données d'entrée contiennent les éléments nécessaires.

|

||||

|

||||

Args:

|

||||

rapport_data: Données pour générer le rapport

|

||||

|

||||

Returns:

|

||||

bool: True si les données sont valides, False sinon

|

||||

"""

|

||||

num_images = len(images_analyses)

|

||||

logger.info(f"Formatage du prompt étape 1 avec {num_images} analyses d'images")

|

||||

|

||||

# Construire la section d'analyse du ticket

|

||||

prompt = f"""Génère les 3 premières sections d'un rapport technique basé sur les analyses suivantes.

|

||||

|

||||

## ANALYSE DU TICKET

|

||||

{ticket_analyse}

|

||||

"""

|

||||

|

||||

# Ajouter la section d'analyse des images si présente

|

||||

if num_images > 0:

|

||||

prompt += f"\n## ANALYSES DES IMAGES ({num_images} images)\n"

|

||||

for i, img_analyse in enumerate(images_analyses, 1):

|

||||

image_name = img_analyse.get("image_name", f"Image {i}")

|

||||

analyse = img_analyse.get("analyse", "Analyse non disponible")

|

||||

prompt += f"\n### IMAGE {i}: {image_name}\n{analyse}\n"

|

||||

else:

|

||||

prompt += "\n## ANALYSES DES IMAGES\nAucune image n'a été fournie pour ce ticket.\n"

|

||||

|

||||

# Instructions pour le rapport

|

||||

prompt += """

|

||||

## INSTRUCTIONS POUR LE RAPPORT (ÉTAPE 1)

|

||||

|

||||

GÉNÈRE UNIQUEMENT LES 3 PREMIÈRES SECTIONS:

|

||||

1. Résumé du problème (## Résumé du problème)

|

||||

2. Analyse des images (## Analyse des images)

|

||||

3. Synthèse globale des analyses d'images (## 3.1 Synthèse globale des analyses d'images)

|

||||

|

||||

POUR LA SECTION ANALYSE DES IMAGES:

|

||||

- Décris chaque image de manière factuelle

|

||||

- Mets en évidence les éléments encadrés ou surlignés

|

||||

- Explique la relation avec le problème initial

|

||||

|

||||

POUR LA SECTION SYNTHÈSE GLOBALE:

|

||||

- Titre à utiliser OBLIGATOIREMENT: ## 3.1 Synthèse globale des analyses d'images

|

||||

- Premier sous-titre à utiliser OBLIGATOIREMENT: _Analyse transversale des captures d'écran_

|

||||

- Explique comment les images se complètent

|

||||

- Identifie les points communs entre les images

|

||||

- Montre comment elles confirment les informations du support

|

||||

|

||||

NE GÉNÈRE PAS ENCORE:

|

||||

- Le fil de discussion

|

||||

- Le tableau des échanges

|

||||

- Le diagnostic technique

|

||||

|

||||

Reste factuel et précis dans ton analyse.

|

||||

"""

|

||||

|

||||

return prompt

|

||||

|

||||

def _formater_prompt_pour_rapport_etape2(self, ticket_analyse: str, etape1_resultat: str) -> str:

|

||||

"""

|

||||

Formate le prompt pour la seconde étape: fil de discussion, tableau JSON et diagnostic

|

||||

"""

|

||||

logger.info(f"Formatage du prompt étape 2")

|

||||

|

||||

# Extraire le résumé et l'analyse des images de l'étape 1

|

||||

resume_match = re.search(r'## Résumé du problème(.*?)(?=##|$)', etape1_resultat, re.DOTALL)

|

||||

resume = resume_match.group(1).strip() if resume_match else "Résumé non disponible."

|

||||

|

||||

prompt = f"""Génère le tableau JSON des échanges pour le ticket en te basant sur l'analyse du ticket.

|

||||

|

||||

## ANALYSE DU TICKET (UTILISE CES DONNÉES POUR CRÉER LES ÉCHANGES)

|

||||

{ticket_analyse}

|

||||

|

||||

## RÉSUMÉ DU PROBLÈME

|

||||

{resume}

|

||||

|

||||

## INSTRUCTIONS POUR LE TABLEAU JSON

|

||||

|

||||

CRÉE UNIQUEMENT UN TABLEAU JSON avec cette structure:

|

||||

```json

|

||||

{{

|

||||

"chronologie_echanges": [

|

||||

{{"date": "14/03/2023 10:48:53", "emetteur": "CLIENT", "type": "Question", "contenu": "Création échantillons - Opérateur de prélèvement : Saisie manuelle non possible. Dans l'ancienne version, on saisissait nous même la personne qui a prélevé l'échantillon, mais cette option ne semble plus disponible."}},

|

||||

{{"date": "14/03/2023 13:25:45", "emetteur": "SUPPORT", "type": "Réponse", "contenu": "Pour des raisons normatives, l'opérateur de prélèvement doit obligatoirement faire partie de la liste des utilisateurs du logiciel et appartenir au groupe 'Opérateur de prélèvement'. Il n'est donc pas possible d'ajouter une personne tierce."}}

|

||||

]

|

||||

}}

|

||||

```

|

||||

|

||||

IMPORTANT:

|

||||

- AJOUTE OBLIGATOIREMENT une entrée pour la question initiale du client extraite du nom ou de la description du ticket

|

||||

- INCLUS OBLIGATOIREMENT la réponse du support

|

||||

- AJOUTE OBLIGATOIREMENT une entrée "Complément visuel" qui synthétise l'apport des images

|

||||

- UTILISE les dates et le contenu exact des messages du ticket

|

||||

- Format à suivre pour le complément visuel:

|

||||

```json

|

||||

{{

|

||||

"chronologie_echanges": [

|

||||

// ... question et réponse ...

|

||||

{{"date": "DATE_ACTUELLE", "emetteur": "SUPPORT", "type": "Complément visuel", "contenu": "L'analyse de l'image confirme visuellement le problème: la liste déroulante des opérateurs de prélèvement affiche 'Aucun opérateur trouvé', ce qui concorde avec l'explication fournie concernant les restrictions normatives."}}

|

||||

]

|

||||

}}

|

||||

```

|

||||

"""

|

||||

|

||||

return prompt

|

||||

|

||||

def _creer_fil_discussion_dynamique(self, ticket_data: Dict, echanges_json: Dict) -> str:

|

||||

"""

|

||||

Génère un fil de discussion dynamiquement à partir des données du ticket et des échanges

|

||||

"""

|

||||

logger.info("Génération du fil de discussion dynamique")

|

||||

|

||||

# Initialiser le fil de discussion

|

||||

fil_discussion = "## Fil de discussion\n\n"

|

||||

|

||||

# Extraire les informations du ticket

|

||||

ticket_name = ticket_data.get("name", "")

|

||||

ticket_description = ticket_data.get("description", "")

|

||||

ticket_create_date = ticket_data.get("create_date", "")

|

||||

|

||||